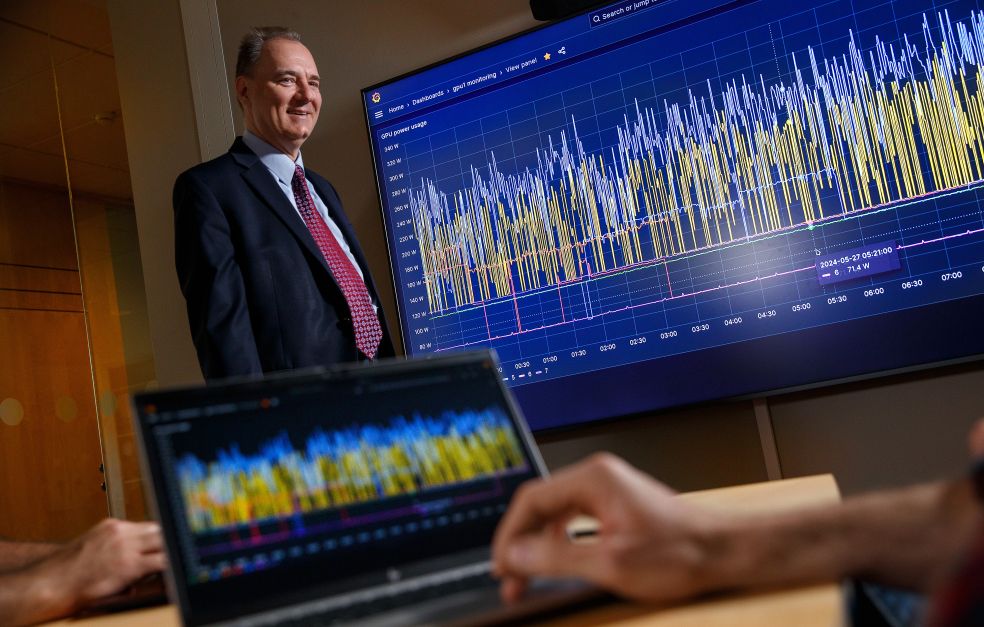

AI-modeller som Chat GPT, Claude och Gemini kräver enorma resurser för att tränas och driva. Wallenberg Scholar Dejan Kostic menar att det är ett demokratiproblem att endast de största företagen har råd att utveckla modellerna. Lösningen kan bli en helt ny AI-plattform.

Dejan Kostic

Professor i internetteknik

Wallenberg Scholar

Lärosäte:

KTH

Forskningsområde:

Internetteknik, ett brett område inom nätverkssystem, till exempel energiproportionella nätverkssystem, tillförlitliga programvarudefinierade nätverk och virtualisering av nätverksfunktioner.

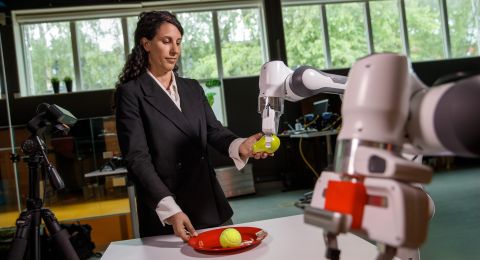

En Chat GPT till varje barn – så beskriver Dejan Kostic sitt mål som Wallenberg Scholar. Förenklat innebär det att skapa en ny plattform enkel och billig nog för att ge varje barn en egen AI-mentor.

– Redan i dag använder många människor i världen olika AI-verktyg – men långtifrån alla. Min vision är att varje barn på planeten ska få tillgång till en egen AI-mentor som kan hjälpa dem att förverkliga sina förmågor, säger Dejan Kostic.

Att lösa den uppgiften med hjälp av dagens teknik är svårt, menar han. För att träna upp en så stor språkmodell som till exempel Chat GPT krävs tillgång till datorservrar med tusentals traditionella processorer och grafikprocessorer, så kallade GPU:er. Endast de specialiserade grafikprocessorerna kan hantera de matematiskt tunga beräkningar som är vanliga inom AI-området.

När väl en språkmodell har tränats färdigt så krävs en liknande tillgång till beräkningskraft för att den ska kunna svara på frågor och lösa problem. Inom artificiell intelligens kallas denna process för inferens och innebär att en utbildad maskininlärningsmodell kan dra slutsatser från nya data.

Sammantaget innebär det enorma investeringar i datorhallar som kräver stora energiresurser och som i många fall resulterar i ökade koldioxidutsläpp.

– Företaget bakom Chat GPT har inte offentliggjort kostnaden för att driva modellen. Men en försiktig uppskattning har gjorts och den landade på cirka en kvarts miljard dollar per år. Det betyder att bara de största företagen har råd att utveckla och driva dessa stora modeller.

Ett annalkande demokratiproblem

Ingen har nog missat de senaste årens AI-boom. Men ännu har ingen lyckats nå AI-utvecklingens heliga graal: en mer generell artificiell intelligens. Det vill säga en AI som kan mäta sig med sättet vi människor tar in och bearbetar information. Den som lyckas nå dit kommer att få en sådan stor fördel att det blir ett demokratiproblem, menar Dejan Kostic.

– Vad händer då med oss andra som inte får ta del av denna nya form av AI?

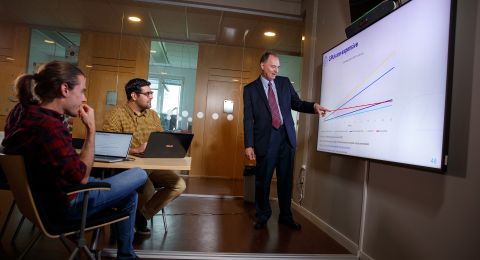

För att undvika att endast ett fåtal får nytta av nya AI-modeller vill Dejan Kostic utveckla en ny plattform för att driva språkmodeller. Plattformen ska göra det möjligt att parallellt implementera flera mindre och specialiserade modeller som ska kunna samarbeta med varandra. Mindre modeller kräver inte lika stora resurser för att drivas, och har även potentialen att ge bättre svar än de större och mer allmänna AI-modellerna.

Detta blir min första stora satsning inom AI-området och jag är oerhört tacksam för stödet från Knut och Alice Wallenbergs Stiftelse.

– Om vi lyckas få dessa mindre expertmodeller att arbeta tillsammans på en ny sorts plattform kan vi förhoppningsvis matcha de stora företagens språkmodeller, säger Dejan Kostic.

Plattformen behöver vara anpassningsbar och kunna hantera att nya språkmodeller läggs till och tas bort under drift, allt utifrån vilka frågor som den behöver lösa. Dessutom ska det vara möjligt att hantera den med enklare teknik än dagens.

Minska energibehovet

En viktig del av arbetet är att minska mängden energi som krävs för att driva en AI-modell.

– Vårt mål är att minska energiåtgången till en tiondel av dagens. Naturligtvis är detta oerhört svårt men att sätta mål som kan synas onåbara är oerhört motiverande.

Dejan Kostic har lyckats tidigare med liknande ambitioner. I ett projekt med stöd av EU:s ramprogram ERC lyckades han öka prestandan tiofalt hos traditionella internetservrar. Ett arbete som gjordes tillsammans med bland andra Ericsson och WASP, Wallenberg AI, Autonomous Systems and Software Program.

Dagens AI-system kräver datorer där fyra grafikprocessorer klustras samman med en traditionell processor. Medan grafikprocessorerna sköter de tunga beräkningarna står den traditionella processorn för kommunikationen. Här finns mycket att vinna både i form av energiförbrukning och snabbhet om grafikprocessorerna i stället kunde kommunicera direkt med varandra.

– Detta är redan möjligt vid träningen av modellerna men inte under inferens. Men vi har redan publicerat viss forskning som visar hur det skulle kunna göras.

Kraftig hastighetsökning

Om de traditionella processorerna kan tas bort kan det minska energibehovet med en fjärdedel. Men den stora vinsten finns i hastighetsökningen. Utmaningen är dock att lyckas få kommunikationen att flöda i rätt takt.

– Utan de traditionella processorerna fattas den naturliga buffert som krävs för att beräkningarna ska kunna flyta. Så här behöver vi skapa lite magi för att lyckas.

Den snabba utvecklingstakten inom AI-området gör att konkurrensen är stenhård. Men det är inget som Dejan Kostic fruktar, snarare tvärtom.

– Slutprodukten av vårt arbete är vanligtvis programvara som vi släpper som öppen källkod, så att andra forskare och företag kan använda den. I dag pågår även en diskussion bland företagen att i högre grad dela resultat med varandra. säger Dejan Kostic.

Text Magnus Trogen Pahlén

Bild Magnus Bergström